Google Apresenta Óculos Inteligentes no TED2025

No evento TED2025, a Google mostrou seus novos óculos inteligentes com um display HUD, embora tenha classificado o produto como “hardware conceitual”.

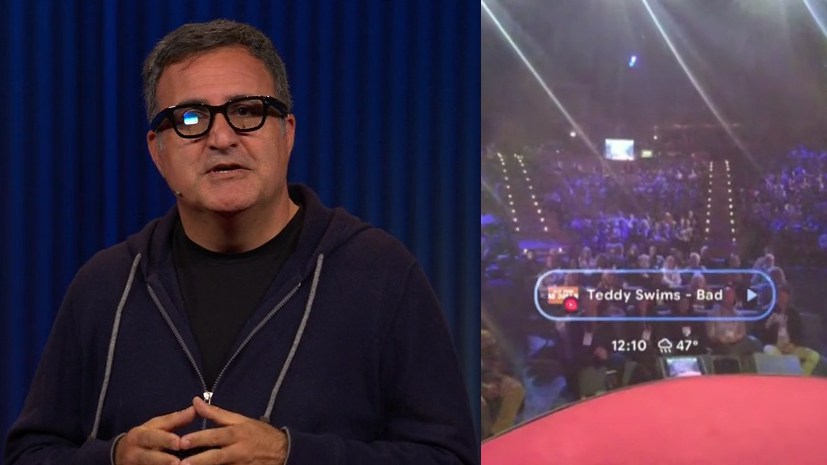

Shahram Izadi, que comanda a parte de Android XR da Google, subiu ao palco do TED e demonstrou tanto os óculos HUD quanto o próximo headset XR da Samsung. Sua apresentação de 15 minutos está agora disponível para ser assistida publicamente.

Uma seleção da demonstração do TED2025.

Características dos Óculos

Os óculos têm câmera, microfones e alto-falantes, similar aos óculos Meta da Ray-Ban, e uma tela miniatura de alta resolução com cores vibrantes. Durante a demonstração, a tela parece ser monocular, refratando a luz no olho direito a partir de certos ângulos de câmera, e possui um campo de visão relativamente pequeno.

Inteligência Artificial em Ação

A apresentação enfatiza o sistema de IA conversacional Gemini da Google, incluindo a funcionalidade do Project Astra, que permite o sistema lembrar o que vê ao “codificar continuamente quadros de vídeo, combinando as entradas de vídeo e áudio em uma linha do tempo de eventos e armazenando essas informações para uma recuperação eficiente”.

Demonstrando Recursos Inovadores

Izadi e sua colega Nishtha Bhatia demonstraram diversas funcionalidades:

- Multimodal Básico: Bhatia pede ao Gemini para escrever um haikai baseado no que vê na plateia, e a IA responde: “Rostos iluminados. Mentes ansiosas esperam as palavras. Centelhas de pensamento acendem”.

- Memória Contextual em Tempo Real: Bhatia se vira para uma prateleira com um livro e pergunta sobre o título do “livro branco que estava na prateleira atrás de mim”. O Gemini responde corretamente. Em seguida, ela faz uma pergunta mais difícil, sem dar dicas, perguntando onde está seu “cartão do hotel”. O Gemini acerta novamente, localizando o cartão à direita do disco de música.

- Multimodal Complexo: Enquanto segura um livro aberto, Bhatia pergunta ao Gemini o significado de um diagrama, e ele responde corretamente.

- Tradução: Bhatia olha para uma placa em espanhol e pede ao Gemini que traduza para o inglês, sem mencionar o idioma. A IA acerta. Para provar que a demonstração é ao vivo, Izadi pede que a plateia escolha outro idioma, e quando alguém escolhe o farsi, o Gemini traduz corretamente novamente.

- Suporte a Várias Línguas: Bhatia conversa com o Gemini em hindi, sem precisar mudar de modo ou configuração de idioma, e ele responde instantaneamente no mesmo idioma.

- Ações (Música): Para mostrar como o Gemini pode acionar funções no celular, Bhatia observa um álbum físico e pede ao Gemini para tocar uma faixa dele. A música começa a tocar no celular dela, transmitida para os óculos via Bluetooth.

- Navegação: Bhatia solicita ao Gemini para “me levar a um parque próximo com vista para o mar”. Quando olha para a frente, vê instruções 2D detalhadas, e ao olhar para baixo, uma minimapa 3D mostrando a rota.

Concorrência no Mercado de Óculos Inteligentes

Essa não é a primeira vez que a Google apresenta óculos inteligentes com um HUD, e já no I/O 2024, a empresa mostrou uma breve demonstração pré-gravada da tecnologia, focando nas capacidades do Project Astra.

Os óculos do ano passado eram significativamente mais volumosos do que os apresentados no TED2025, o que sugere que a Google está buscando uma miniaturização para oferecer um produto viável.

No entanto, Izadi ainda se refere ao que a Google está mostrando como “hardware conceitual”, sem anunciar nenhum produto específico ou cronograma de lançamento.

Recentemente, surgiu a informação de que a Samsung está desenvolvendo um concorrente dos óculos Meta da Ray-Ban com a IA Gemini da Google, mas ainda não há clareza sobre a inclusão de um HUD nesse produto.

Outras Empresas Apostas no Futuro dos Óculos Inteligentes

Se os óculos da Samsung realmente contarem com um HUD, não estarão sozinhos no mercado. A Meta, de Mark Zuckerberg, também planeja lançar seus próprios óculos inteligentes com HUD ainda este ano.

Como os óculos da Google, os protótipos da Meta devem ter uma pequena tela no olho direito e foco em IA multimodal. Contudo, a diferença é que, além de comandos de voz, os óculos da Meta poderão ser controlados por gestos de dedos, captados por uma pulseira neural que ficará na caixa.

Até a Apple está de olho nesse mercado, com planos de lançar seus próprios óculos inteligentes em 2027.

Expectativas Futuras

As três empresas parecem estar mirando no sucesso inicial dos óculos Meta da Ray-Ban, que já ultrapassaram 2 milhões de unidades vendidas, prevendo um aumento considerável na produção.

A competição entre os gigantes da tecnologia promete ser intensa nos próximos anos, à medida que eles buscam dominar a IA que vê e ouve o que você vê e ouve, e a capacidade de projetar imagens em sua visão a qualquer momento.